别的再用 Claude 了,现在国产模型 kimi-k2、 GLM-4.5 等都比 Claude 模型更强了

发布于 2025年9月8日

Anthropic 在 9 月 5 日更新了封锁地区的公告 Updating restrictions of sales to unsupported regions。一家科技公司却充满攻击性的政治言论,至此,我已经不再为 Claude 买单了。

之前 Claude 模型确实是 Agentic Coding 领域独一档的存在,但是现在他的地位正在被打破。最新的基准测试显示,国产模型 kimi-k2、GLM-4.5 和 Qwen3-Coder 在 Agentic Coding 能力上已经追平甚至超越 Claude。

根据 LMArena WebDev 领域的最新排名数据,国产模型的表现非常好:

- GLM-4.5 接近 Claude Opus 4 的水平。

- Qwen3-Coder 也跟 Claude Sonnet 4 不相上下。

- kimi-k2 应该也跟 Sonnet4 不相上下。(天梯榜放的还是 0711 版本的,新版本应该排名更靠前。)

更重要的是,这些国产模型不仅性能强劲,成本也比 Claude 低。本文将详细对比kimi-k2 和 GLM-4.5 两个模型的特点,并提供在 Claude Code 中的完整配置方法,帮你找到最适合的 Claude 替代方案。

Kimi-k2

Kimi K2 在 0905 发布最新版本,Agentic Coding 能力提升,上下文达到 256K,工具调用 100% 格式正确。

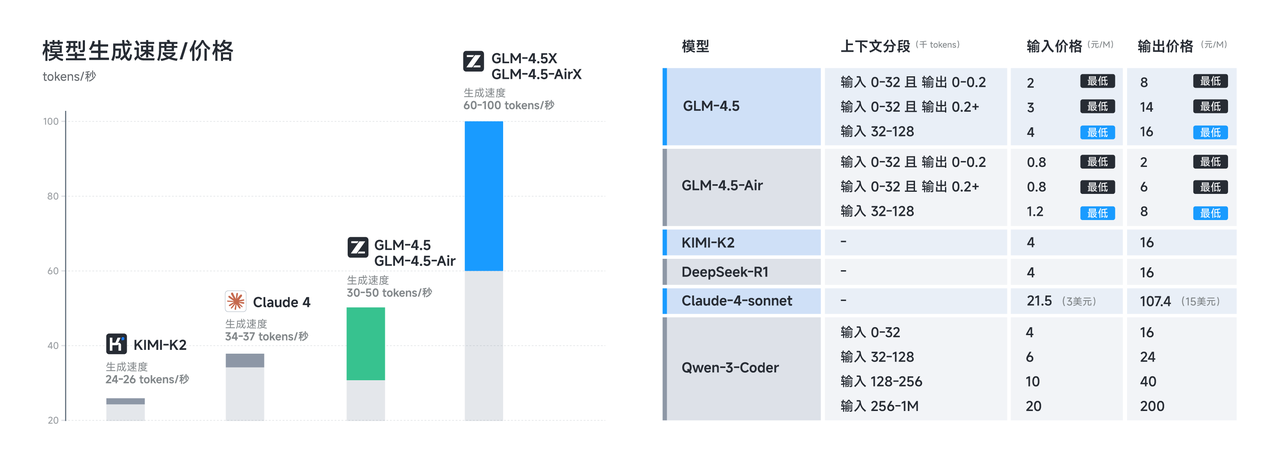

模型与费用

kimi-k2 除了 kimi-k2-0905-preview 版本(输出速度只有 24-26 tokens / 秒)。他有个对应的极速版本 kimi-k2-turbo-preview,输出 60-100 tokens / 秒。能力一致。

价格方面(每 1M tokens):

- kimi-k2 缓存命中 1 元,输入 4 元,输出 16 元。

- turbo 版本,缓存命中 4 元,输入 16 元,输出 64 元。

限速:

kimi 对不同的充值金额做了速率限制,Free 层级的 RPM 只有 3 几乎无法正常使用 Claude Code。达到 Tier1 后体验正常。

详情见 Moonshot AI 模型推理定价。

接入 kimi-k2 到 Claude Code

创建 API key:

我建议你新建一个专门用于 Claude Code 项目。方便查看 Claude Code 消耗量。

API KEY 配置:

我习惯把环境变量配置到 ~/.claude/settings.json 中。

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "YOUR_MOONSHOT_API_KEY",

"ANTHROPIC_BASE_URL": "https://api.moonshot.cn/anthropic",

"ANTHROPIC_MODEL": "kimi-k2-0905-preview",

"ANTHROPIC_SMALL_FAST_MODEL": "kimi-k2-0905-preview"

}

}

配置完成后在 Claude 中执行 /status 查看当前的状态。

GLM-4.5

GLM-4.5 系列都是 MoE 架构,GLM-4.5 总参数 3550 亿,激活参数 320 亿。

模型与费用

GLM-4.5 有 5 个版本。我们主要看下面两个

- GLM-4.5

- GLM-4.5-Air

他们生成速度为 30-50 tokens/秒,他们分别都都有对应的极速版本,GLM-4.5-X 和 GLM-4.5-AirX。生成速度达到 60-100 tokens/秒。

价格方面(每 1M tokens):

做了上下文分段,输入输出的上下文越长价格越高。缓存暂时都免费。

- GLM-4.5 输入 2-4 元,输出 8-16 元。

- GLM-4.5-Air 输入 0.8-1.2 元,输出 2-8 元。

- GLM-4.5-X 输入 8-16 元,输出 16-64 元。

- GLM-4.5-AirX 输入 4-8 元,输出 12-32 元。

详情见 智谱AI 模型介绍 GLM-4.5。

目前注册就送 2000万的 tokens。你可以通过我的邀请链接https://www.bigmodel.cn/invite?icode=1RXH2G8moSnmDjU0oqdgMQ%3D%3D 注册,再获得 2000 万的 tokens。

接入 GLM-4.5 到 Claude Code

API KEY 配置:

// ~/.claude/settings.json

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "YOUR_API_KEY",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"ANTHROPIC_MODEL": "glm-4.5",

"ANTHROPIC_SMALL_FAST_MODEL": "glm-4.5-air"

}

}

配置完成后在 Claude 中执行 /status 查看当前的状态。

各个模型横向对比

代码生成能力:

Claude Opus 4.1 > GLM-4.5 ≈ Kimi-K2 ≈ Claude Sonnet 4

上下文长度:

Kimi-K2 (256K) > Claude (200K) > GLM-4.5 (128K)

性价比:

GLM-4.5 > Kimi-K2 > Claude

生成速率:

GLM-4.5 > Claude > Kimi-K2

注:这个仅对比普通模型和官方渠道。非官方渠道比如 Groq 中的 Kimi-K2 可以达到 200 Tokens / 秒,比如官方的 turbo 还快,完全无法对比。

综合而言,GLM-4.5 和 Kimi-K2 都很不错。GLM-4.5 性价比最高,你可以先尝试使用,他还有一个编码套餐 每 5 小时可以调用 120 次 prompts,Claude Pro 套餐 的 3 倍用量,价格仅 20 元。

然后再考虑尝试使用 Kimi-K2(需要充值达到 tire1 层级),Kimi-K2 在工具调用能力上可能会更好,而且内置了网页搜索。GLM-4.5 需要你自己配置网页搜索的 MCP。

结语

国产模型在代码生成能力上已经追平 Claude,成本却更低。无论你选择 Kimi-K2 还是 GLM-4.5,都能获得不错的编程体验。

国产模型的崛起为我们提供了更多选择,Claude 也并没有完全的断崖式的领先地位,相信到了年底,我们国产模型在 Agent 和 Coding 领域会全面赶超。

PS: 本文并没有过多提及 Qwen3-Coder ,因为阿里云百炼不支持 claude 格式 api,所以无法很方便的在 Claude Code 中集成,我也没有花太多精力测试。不过你可以使用 Qwen Code qwen 推出的 code CLI 工具(fork 了 Gemini CLI) 来尝试使用。

如果你觉得这篇文章对你有帮助,欢迎点赞、分享,你的支持是我持续创作的最大动力!

相关资源: